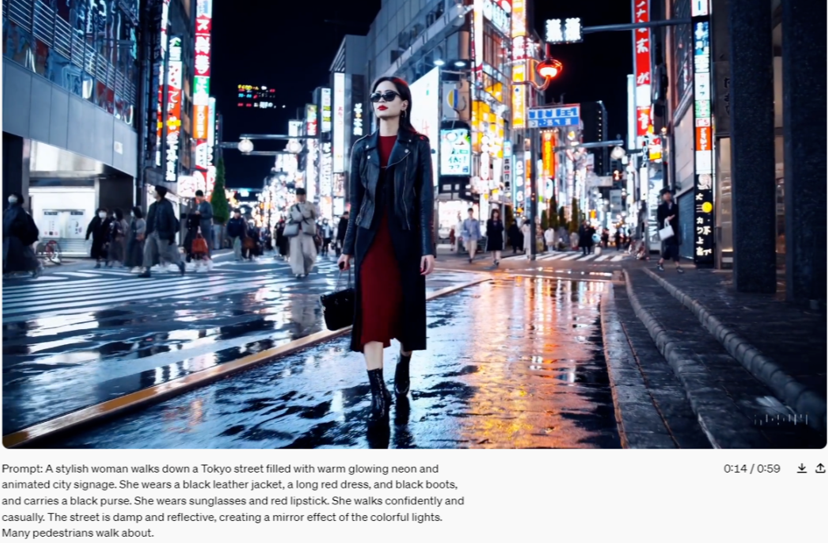

最近,OpenAI突然发布首款文生视频模型—Sora。

很多人试用之后感叹:AI视频要变天了!

Sora不仅能够根据文字指令,创造出宏大、精美且颇具想象力的作品,运镜角度也能达到大师的水平。

而且,它的制作长度达到了1分钟,比现在最好的Runway Gen 2、Pika等AI视频工具的几秒视频强了几倍。

说实话,这本来应该是只有影视行业在意的事情,但万万没想到,国内又开始有人反思了。

有人说这意味着第N次的工业革命又被欧美人开启了,有人说面对算力芯片的封锁中国的国运又要再次沉沦,还有人引申吐槽国内的科研人员都在琢磨人际关系,搞不出来这种颠覆性的成果来。

那么,Sora到底是个啥?到底厉害在哪里?在AI领域,中美真正的差异在哪里?

1 Sora的原理和厉害之处

其实吧,别看现在写Sora的文章满天飞,原理机理头头是道,还有人开始趁机卖Sora的课程乃至变现课程了,但绝大部分不靠谱。

为啥?

因为Sora根本没公测呢!

OpenAI公布的,只是Sora发布的几个视频,而且至今没对公众开放Sora的测试权限。

事实上,OpenAI公开表示,为了保证Sora的安全性,需要经过红队安全测试之后再考虑面向公众开放。

所谓“红队”可以理解为模拟黑客团队,目前只招收居住在美国的人,也就是说,国内用户现在连内测的机会都没有。

而就在2月15日,OpenAI官网首次列出中国、俄罗斯、伊朗、朝鲜几个所谓国家附属行为AI威胁参与者,并终止相关OpenAI账户。

连测试还没有测试,甚至连测试的资格都没有,咱们网上那些课程和解读是哪来的?

可想而知。

目前,唯一可以一探Sora奥秘的渠道,就是OpenAI官网关于Sora背后的技术理论的简介。

内容比较抽象,一般人看不懂,不过Sora的技术来源之一的Transformer的作者、上海交大天才少年、纽约大学助理教授谢赛宁啃完了OpenAI附件的32篇的论文,对内容做出了分析,也许我们可以一探究竟。

Sora最大的创新,是在论文中,提出了一个SpaceTime latent patch的概念。

你可以把它理解为一个“时空图像块”,每个“时空图像块”就相当于语言模型的token。

Sora的原理,就是通过你的提示词,提取关键字,比如主题、动作、地点、时间和情绪。

再从它的数据集里搜索与关键字匹配的、最合适的时空图像块。

然后按照数据集中其他时空图像块的之间逻辑,猜测自己的下一个时空图像块是什么。

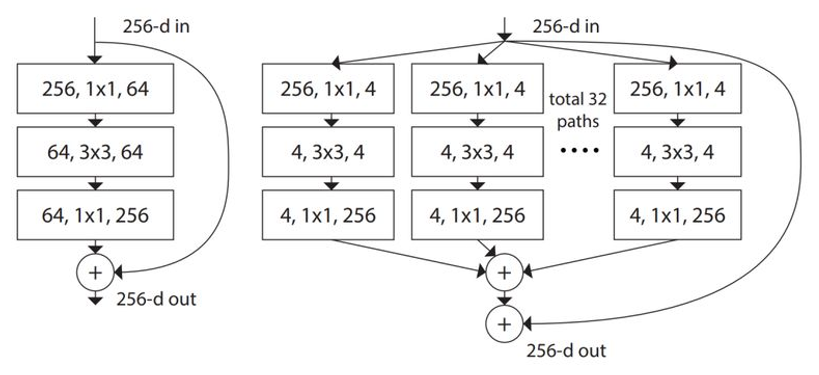

最后通过LDM的建模方法+DiT的模型结构的生成能力,在时间轴上生成了一个连续的视频。

Sora最强大的能力,其实就在这一点上:

它不是通过单帧画面想象的,而是通过一个个时空图像块,然后来构成整个场景。

所以它天然适合生成连贯的视频,而且这个视频还能保持一致性、一惯性(比如人物的衣服不会发生变化)。

咱们通俗地打个不是十分贴切的比方。

你让Sora给你做个《三体》的视频,它要在数据集中先读一遍三体,然后给每一个角色,都建立了一个故事线。

谁和谁在一起,做了什么,然后所有角色和情节构成了很多网。

这样他就能通过网上交织的这一个个的时空图像块,按照你的提示词来构成整个画面。